Codeforces & Topcoder

简介

- codeforces

- Codeforces 是一家为计算机编程爱好者提供的在线评测系统

- 该网站由俄罗斯 ITMO 大学(圣彼得堡国家信息技术、机械学与光学研究型大学)的一个团体创立并负责运营。

- 在编程挑战赛中,选手有 2 个小时的时间去解决 5 道题,通过得分排名,选手可以看到实时的排名(Standing),也可以选择查看好友的排名,还可以看到某题有多少人通过等信息。

- 在 cf,所有的用户根据在以往比赛中的表现被赋予一个 Rating 并冠以不同的头衔,名字也会以不同的颜色显示,比如 Expert 是蓝色,Master 是黄色。

- 题目兼容并蓄,什么难度等级的题目都可以找到。

- 并且题目很有意思,往往思维陷阱比较多,也就是思维题比较多。

- 对于数据结构以及算法的考察相对弱一些,更多的时候往往是告诉你用什么算法你也不知道怎么做。

- topcoder

- TopCoder成立于2001年,它的客户包括Google、MS、YAHOO、Intel、 Motorola和SUN等世界上顶级的IT公司。每年TopCoder都会举办若干个编程竞赛和锦标赛,其总奖金金额高达几十万美元。她是你进入世界顶级的IT企业的捷径,TopCoder排名(程序设计,开发,算法)靠前的选手基本都成了知名公司追逐的对象。

- 积分:tc的每个用户(handle)都有自己的积分,从0-3000+不等。成绩越好,分数越高 。

- 积分与颜色的对应为:白色——未参赛(unrated);灰色——0899;绿色——9001199;蓝色——12001499;黄色——15002199;红色——2200+。另外排名最高的几个人在TC客户端中会变成红色靶子图标。现在,全世界有300人达到红色等级,日本有26人。3000 分以上者被称为target,全世界有18人,日本有3人,分别是:iwi(秋叶拓哉)、wata (岩田阳一)和lvrically;

topcoder vs codeforces

Codeforces: Another good platform with nice contests where you will get to learn new things that will improve your understanding of concepts. It's ratings don't matter to recruiters but the things you'll learn will help you during interviews and company's coding tests.

TOPCODER: This caters to every aspect of software develpment. They have both designing and development contest. Major companies provide Topcoder community to experment with their nw products or APIs. But if you want to mention it in your CV, your ratings should be above 1400 to impress a recruiter.

for average is CODEFORCES, for expert TOPCODER

竞赛说明

codeforces

- 比赛举办频率

- 第一种是Codeforces Rounds(常规比赛) 大约一周一两次,时长2小时。常规赛分为三个赛区:Div3、Div2和Div1。题目难度Div3 < Div2 < Div1。

- 第二种是Educational Contests(教育性比赛) 大约每个月二到三次,时长2个小时。常规赛分为两个赛区:Div2和Div1。题目难度Div2 < Div1。

- 比赛一般是两个小时的赛程,一共六道题目。(20分钟一题)

- 新手能做出3道,rating就不会跌。

- div 表示题目难度,数值越小难度越高,

- div 1 要求参赛者的 Rating 大于 1900 。div2 平均难度在 Rating 1500.

- Hack:当你通过某题目,可以查看同房间内其他通过该题的参赛者的代码。

- 由于codeforces在比赛的时候只会测试一小部分数据,真正的测试集会放到赛后进行测试。所以在比赛中测试通过的代码,只是通过了小数据验证,很有可能有隐藏的问题没被发现。

- 如果发现了bug,可以构造一份数据hack掉他的提交。

- hack 成功,你获得 100 分奖励,别人的提交会被打回;hack 失败,减 50 分作为惩罚。

- 一般后面题不会做的时候,又有时间的时候就去Hack

topcoder

- 安装程序TopCoder Arena(竞技场,古罗马的斗兽场也是这个词),

- TopCoder Arena是一个纯Java应用程序,它既是Applet也是应用程序,所以需要安装Java运行环境。

- 相关软件的网址ContestAppletProd.jnlp(Java Web Start 方式安装)

- 规则

- 75分钟做完3道难度递增的题。(25 mins per problem)

- 比赛分为两个division:Div I和Div II。

- 积分

<1200或者unrated(即注册但还没参加过比赛的)参加Div II,>=1200的参加Div I。 - Div I的题要比Div II难许多。 一般DivII的最后一题和Div I的第一或第二题是一样的。

- 无论是Div I或Div II。三道题目的Score一般为250, 500和1000左右,视每次的难度略有浮动。

- 积分

- 个人积分 (rating)的增减是根据你和别人在比赛中的score以及你们原来的rating决定的。tc 的提交结合了ICPC和IOI的特点,即只能交一次,必须过所有数据并且得分与用时相关。tc每周有一次Single Round Match(SRM),每年两次大的比赛TCOpen(有$)。

- 评分是根据你完成的时间和所完成问题的难易决定的。

- 比赛可分为三部分:Coding Phase, Challenge Phase和System Test Phase

- 发送代码后,你就进入Challenge Phase了,Challenge Phase部分是让参赛者浏览分配在同一房间的其他参赛者的源代码,然后设法找出其中错误,并提出一个测试参数使其不能通过测试。如果某参赛者的程序不能通过别人或系统的测试,则该参赛者在此题目的得分将为0。

- System Test Phase: 挑战结束后,TopCoder会测试每个参赛者的代码,如果你的代码产生了不正确的输出、异常终止和其它错误,你就不能得分。

- 如果是多个回合比赛,每个小组中得分最高的三位参赛者将进入下一轮的比赛。他们将解决一些新的问题,最后总得分在前三名的选手将会得到现金奖励。

- 参赛具体操作, 图文

other platform

Actual experience

codeforces

- 22:35PM - 01:05 AM

topcoder

- Contest time infomation is here.

- SRM 849 on September 28, 2023 at 11:00 AM - 1:00 PM EST(UTC-4). (00:00 AM - 2:00 AM UTC+8)

- hard to read due to the tiny font.

- maybe copy the problem to outside

需要进一步的研究学习

暂无

遇到的问题

暂无

开题缘由、总结、反思、吐槽~~

参考文献

https://blog.csdn.net/qiuzhenguang/article/details/5552122

https://zhuanlan.zhihu.com/p/540098105

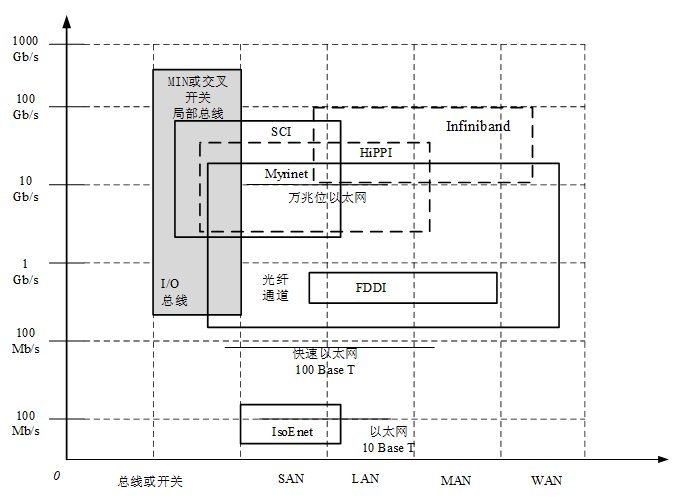

System Area Network(系统域网):主机及外设

Local Area Network(局域网):以太网

Metropolitan Area Network(城域网):WiMax

Wide Area Network(广域网):因特网,X.25

System Area Network(系统域网):主机及外设

Local Area Network(局域网):以太网

Metropolitan Area Network(城域网):WiMax

Wide Area Network(广域网):因特网,X.25

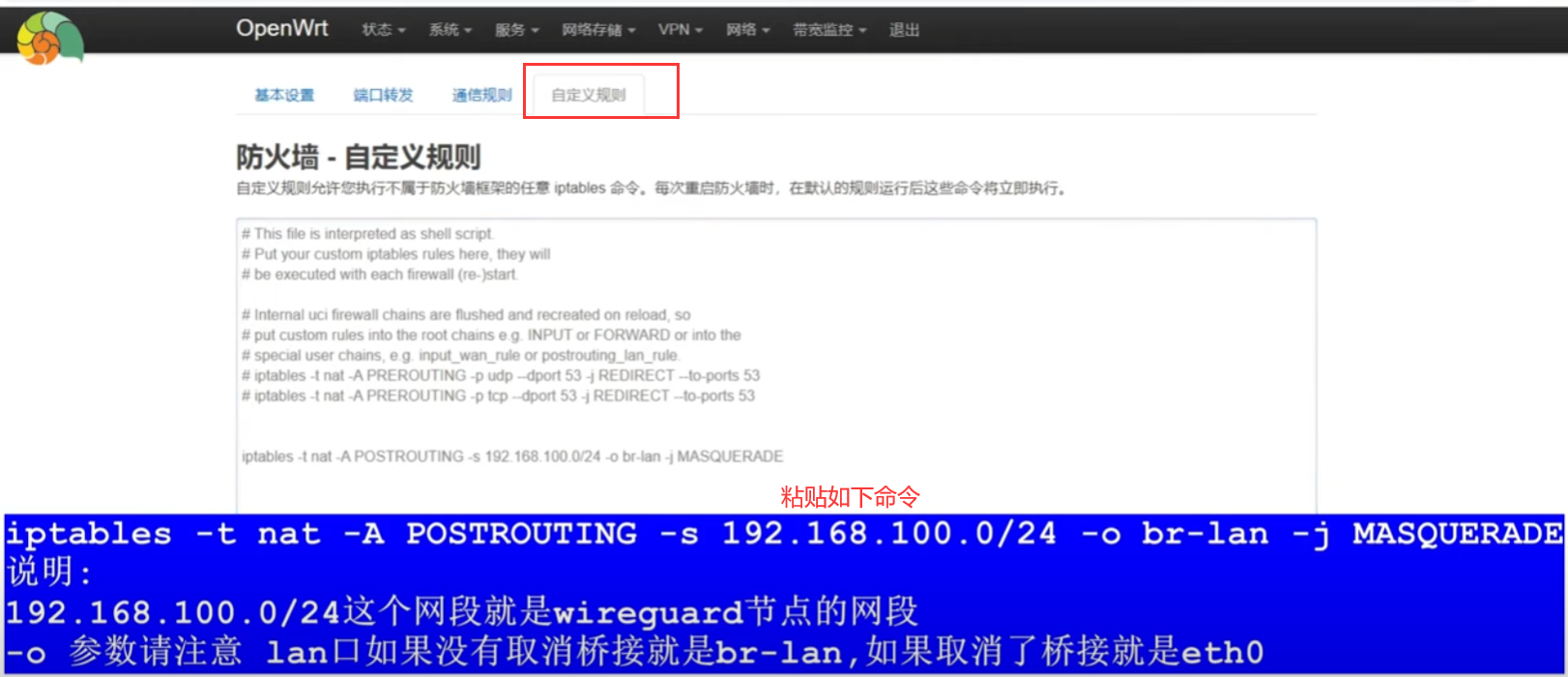

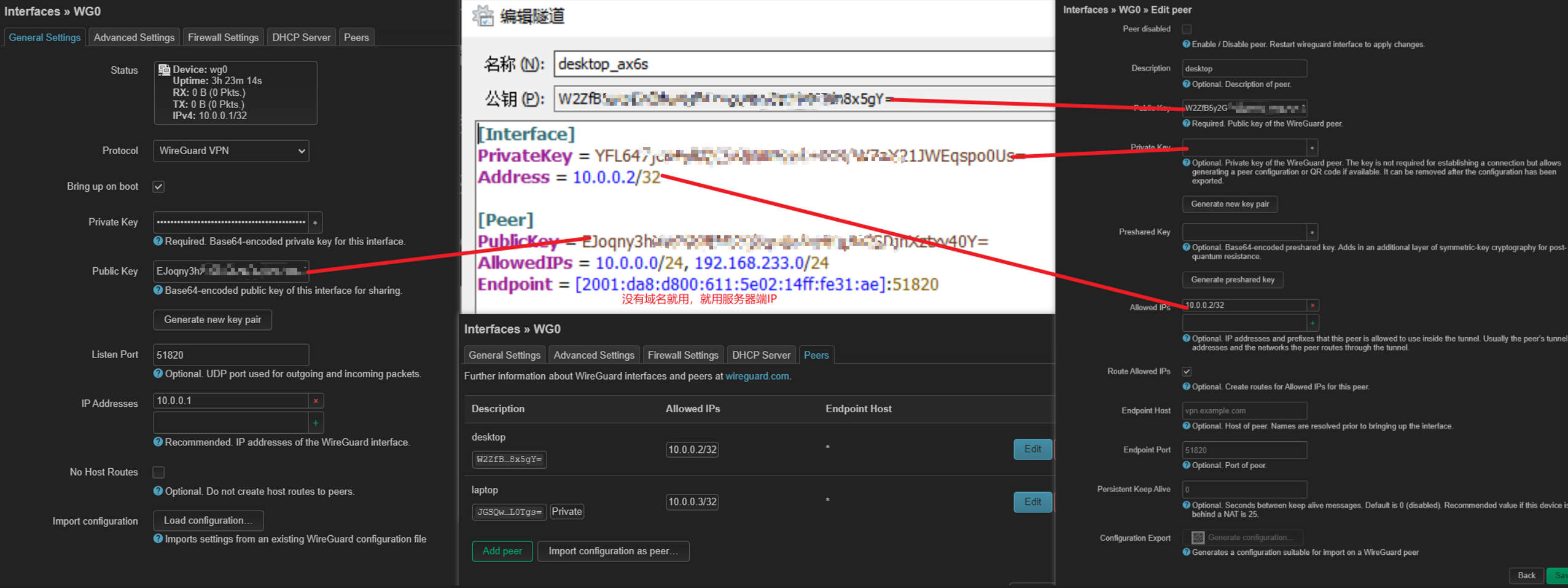

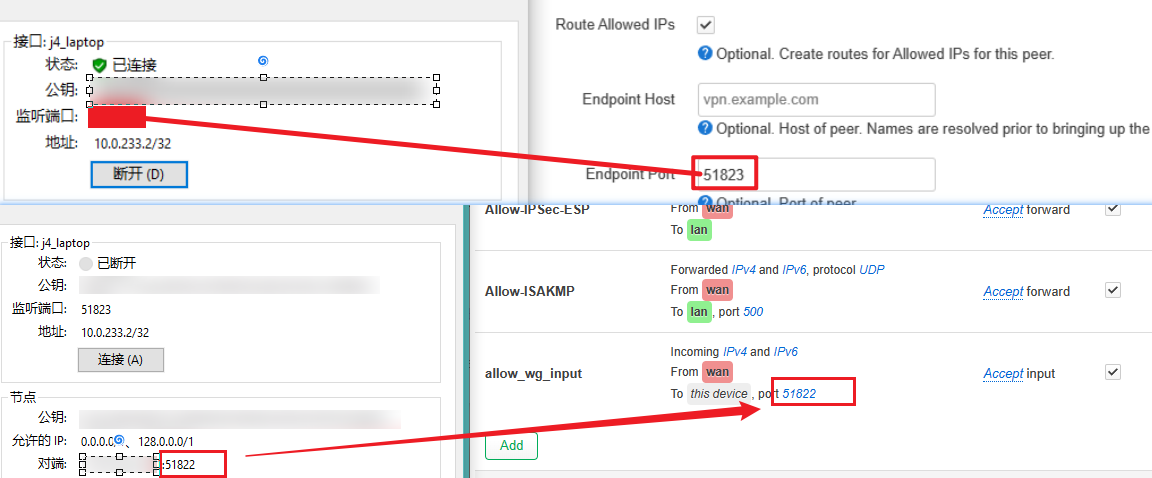

1. 左下角

1. 左下角 注意防火墙放行端口

注意防火墙放行端口

1字节=1B,1024B=1KB

1字节=1B,1024B=1KB 我以为我是修改错文件了,但是好像没怎么简单

我以为我是修改错文件了,但是好像没怎么简单 后来发现原因是,变量这一行不要加注释

guest_enable=YES

后来发现原因是,变量这一行不要加注释

guest_enable=YES

这很明显是没有指定用户

这很明显是没有指定用户